AI 演算法,CNN之父Yann LeCun! 因為他在1989年發表的全球第一個CNN框架LeNet-5,就是源自1950、1960年代的理論,但是,採取了全新的視野,反而掀起了現代深度學習的新革命。

備註:卷積神經網路(Convolutional Neural Networks, CNN)

當時 CNN 演算法發明的時代,在1989年的背景

1. 硬體運算效能,

2. 資料收集的正確性,

這兩項都有問題,所以,以當時1989年的背景 AI 演算法CNN ,是無法成功的。

現在 CNN 演算法為什麼能成功,

因為 IC 設計的算力大量提升,

所以,

未來AI的重點要放在「硬體加速」.

常見的硬體加速

GPU

FPGA

ASIC (成本過高,很少有公司可以負擔)。

====台積電先進製程20231220中信整理==

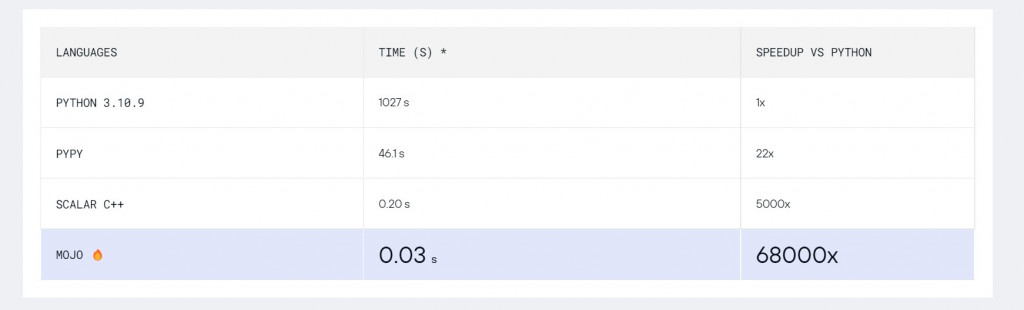

====我是分格線=Mojo 使用軟體操作 GPU、FPGA、ASICs與 python 相容 20230917

Mojo 編程語言旨在與 Python Project Jupyter 生態系統完全兼容。 它尚未與 Python 3.x 代碼完全源兼容,僅提供其語法的子集。Mojo 運用世界上最先進的編譯器和異構運行時,充分利用硬體的功能,包括多核、向量單元和奇異的加速器單元(GPU、FPGA、ASICs CPUs and GPUs, such as AI ASICs, quantum computing systems, FPGAs, and custom silicon.)。 無需複雜性即可實現與 C++ 和 CUDA 相當的性能。

====我是分格線=

備註: 在2019年, 要開一個ASIC 台積電 7n(奈米) 大約需要一億美金(30億台幣)。

目前的 AI 發展依據 AI SoC(系統單晶片)的實際體積大小進行分類有1. 雲端(Cloud)、2. 邊緣運算(edge computing)。本文主要討論 AI 在雲端主機(HPC高效能伺服器)的「硬體加速」。

關於2.邊緣運算(edge computing)

舉例, Google pixel 7 就是把部份 AI 運算放在手機,來淢少 Google server(伺服器)的運算量(workload),所以,Google 台北板橋的軟體、硬體研發中心,對於Google 全球戰略非常重要。

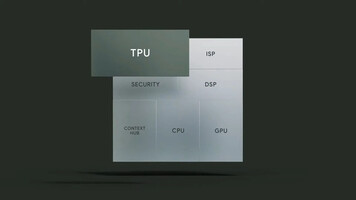

Google Tensor g2 IC 架構圖(2022年)

目前的Google IC 發展的狀態是把 CPU,GPU,DSP,TPU,ISP,等元件整合在一起。回顧歷史在 2006年時的電腦架構是把 DSP 單元做在 CPU 外面,當 DSP 運算完後,再把資料(Data) 回傳至 CPU 運算。目前2022年,都把許多單元(Units)整合在一顆IC 內,主要是因為 IC 製造業近十多年製程的進步神速,已經到了2奈米製程,小結論「時代不同,施做的工法也不同。」

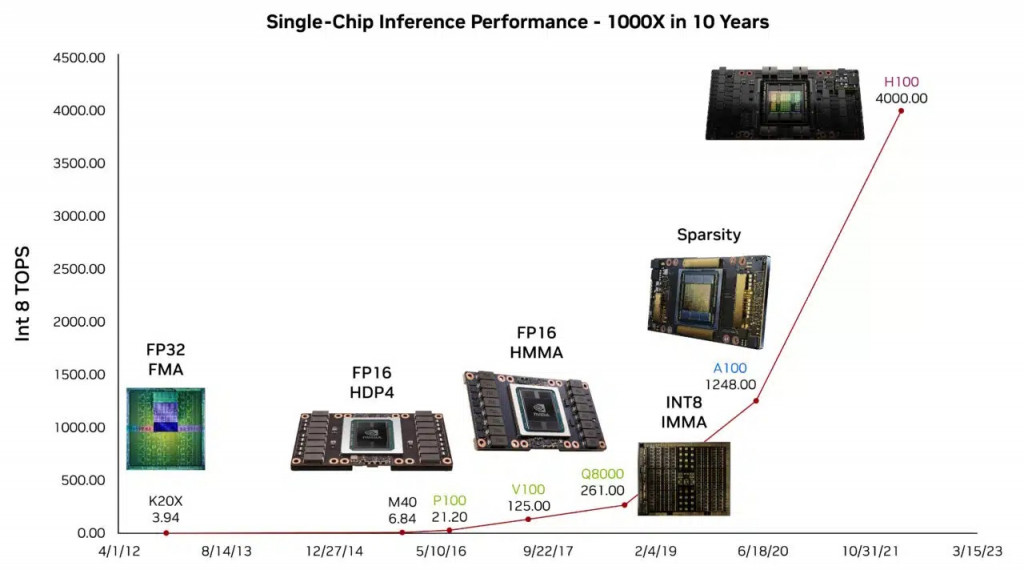

====我是分格線===關於Nvidia GPU 的效能演進圖===

2023/09/01

單 GPU 性能的提升只是更大故事的一部分,其中包括在擴展到數據中心大小的超級計算機方面取得了數百萬倍的進步。

(Gains in single-GPU performance are just part of a larger story that includes million-x advances in scaling to data-center-sized supercomputers.)

這個圖片是我從Nvidia blog 轉貼來的,因為我覺得非常值得跟讀者分享。

圖片來源連結

==我自已使用GPU的心得====我是分格線====

NVIDIA 的GPU 核心數,在近兩年有大輻的增加,

而且,是大量飛快的增加核心數。

RTX 4090是2022發表的,

RTX 3070是2021發表的,

18,432 cores, how many cores on nvidia Geforce RTX 4090?

5,888 cores, how many cores on Nvidia Geforce RTX 3070?

所以,拿 GPU 當硬體加速器,速度會快很多,

NVIDIA GPU Design 有很多台灣的電子、電機博士在台北內湖裡設計。

我自已拿 RTX 3060 Ti 版來打電動,其實滿爽的,畫質很好

GTC 2020 May

===CNN論文在台灣發表篇數===

另一個資料統計,我查詢「臺灣博碩士論文知識加值系統」 CNN,總共有478筆資料,

我剛好查到「台北科技大學」「電子工程系碩士班」使用FPGA做硬體加速,

論文全名:「基於FPGA之卷積神經網路硬體加速設計」,2022年,

所以,硬體加速AI演算法,是正在發生的事情,

大家都是有志一同,投入硬體加速的世界。

===ASIC ===2019年設計價格==

依據台灣清華大學 資訊工程系 李永隆教授 2019年資訊,

要開一個ASIC 台積電 7n(奈米) 大約需要一億美金(30億台幣)。

==關於「資料正確性」後續補充======

我把 AI 訓練模組粗略分成 1.圖片 2.資料(數字、文字)這兩種。

以下是以圖片訓練AI模組時,可能會遇到的奇異狀況。

圖片的最左邊是1. 魔戒 咕嚕 2. 小孩 3. 小孩。

AI 因為 資料而誤判:

假設

今天我打算訓練圖片辨識小孩的系統,

如果我沒有跟AI 模組說: 「圖片1.是 魔戒 咕嚕」,AI可能會依據

圖片1. 魔戒 咕嚕

AI 就把,魔戒 咕嚕,判斷為「小孩」,這是錯誤的結果。

===台積電第二季法說會2023/07/24===

台積電上周的法說會,提問者查理先生有提問「ASIC的市況」

(在下面影片連結的 57分)

台積電 的回應大意為: 「客戶對於ASIC 有很高的需求,

所有的CPU, GPU, ASIC 等等 AI 硬體加速都需要台積電的先進製程,這是台積電的強項(strengths)」。

台積電第二季法說會影片連結2023/07/24

===本篇文章的由來=

前科技部長陳良基部長,是從2016年引導台灣科學家從事AI 相關發展,最重要的人士之一。

陳良基部長提出: 「算力是 AI 的關鍵」, 我由這句話去衍伸 AI 的硬體加速。

比喻如果是在電玩遊戲:

把「陳良基部長」比喻成「SSS頂級召喚師」,

而我的存在就是自「陳良基部長」召喚術出來的「占卜師」,

我是軟體工程師,我把自已比喻成「占卜師」很適合不過。

身為「占卜師」的我,雖然體力上比較差強人意,

但是,

我有一個特殊技能,就是「預知未來科技走向」。

「陳良基部長」不止把我召喚出來,更把一群有志之士集結出來,

有的人是「狂戰士」、「聖騎士」、「惡靈法師」、「固執矮人」、「精靈神弓手」,每個人都戰鬥力十足。

我們是一群人,

不是一個人,

從事 AI 領域研發與發展。

20230827 Youtube 陳良基部長 影片

===小段落分格線==

2023年1月,就在我第二次面試Google Technical Lead 失敗後三天,Google 就公告全球大裁員,

就在我最失落的時刻,我傷心了一天,我傷心是因為我2022年花了一百萬台幣在面試 Google,

我的內心非常的失落,我一直在找是那邊有問題,我的內心充滿疑問「難道是因為我沒有碩士學歷?」

然後,我就跑去報名 國立雲林科技大學-電機系-碩士在職專班。

碩士在職專班,考試的最後一關是[教授面試] 由三位優秀留美的通訊博士主持,

其中一位教授(面試官)還是前通訊所所長,

而我面對三位專業的教授,我講的主題就是: 未來AI的發展重點要放在「硬體加速」,

電腦的硬體加速有三種:

~~

Note: 2023年3月碩士在職專班考試完,我4月就寫這篇文章發表在「IT邦幫忙」,

因為我知道「IT邦幫忙」裡有數以萬計、實力很堅強的技術專家在這個論壇,所以,我只發表在這裡。

~~

****本篇文章的由來 END *******

結論:

我想起 AMD CEO 蘇姿丰 博士的 爸爸-蘇春槐 博士說:

「塔木德經裡面有一段話,"好" 不一定好,

"壞" 不一定壞」

Version:2023033101

關於:

Billour Ou 歐育溙

簡歷:

Google Technical Lead 技術主管 面試邀請

國立雲林科技大學 電機系 碩士班入學考 第一名(榜首)

台灣教育部 DSP 競賽全國, 第一名

台灣工研院 嵌入式 FPGA 系統加速應用程式設計證照(Verilog)

台灣勞委會 電腦硬體裝修 乙級

台灣勞委會 工業電子 丙級

#ai

資料收集的正確性呢? :-O

樓主應該是指training data, 有時候爬蟲軟體,爬到的data,不一定適用or合用,所以還需要人工介入.

你好,我有更新文章,如果有任何問題,再麻煩留言在本篇,謝謝。

剛發現 OpenAI, 有在往標題"硬體加速" 方向前進,正在開發GPU程式語言. 分享給大家.

https://openai.com/research/triton

https://github.com/openai/triton

Web爬蟲的資料會有"正確性"、"乾淨度"的問題,所以近幾年興起"合成資料",Google前工程師爆料…前東家拿ChatGPT…

感謝留言,你好,我有更新文章,如果有任何問題,再麻煩留言在本篇,謝謝。

因為你的留言,我才學習到「合成資料」這個概念。

感謝留言。

硬體加速跟AI訓練我認為有三個路子

期待一下ROCm,這東西雖然還在發展,但是比CUDA的架構還來得寬廣

想說

1.應該是DOS 不是DDOS,大哥應該不會專門開多機器去餵資料吧XDD

2.因為前面在說AI的硬體加速,但後面說到訓練模型的部分 SERVER爆炸 因而找尋加速AI運算。怕有人搞混,想說 一般終端,應該更多的是加速AI"應用模型"的運算,但不是在"訓練模型"的部分

我的本文文章語意應該再修正一下比較好,

如果我找到時間,我再回想一下我在2019做的30萬筆資料「實驗」的架構圖,

不過,要回想三、四年前的東西,

我要先把之前的資料、註解找出來,

這個部份我可能需要花點時間。

你好,我把本篇的由來那一小段文章重寫了,2023/08/28

這篇是我發表在Linkedin,目前五百人觀看。

因為現在2023年正處於 IT 市場的轉變中,所以,我花了點時間在2023/5/29 (星期一)參加輝達(NVIDIA) 黃仁勳 2023 computex 演講。主要會議講述 GPU 的未來及GPU 的應用,這個有助於學生就業、資訊人員轉換行業別。

但,我覺得這篇會被刪掉,如果這篇對你有幫助,再請你自行備份,

這是我寫的,只要註明出處都可以自由轉貼。

輝達(NVIDIA) 黃仁勳 2023 computex 演講

科技業未來的機會:

備註: 車用市場(高階車用晶片),正式由三大科技公司競爭

1. 高通 2. AMD 3. 輝達(NVIDIA)

科技產業的定理:只有市佔率第一名的公司可以存活。

敵人的敵人是朋友; 「高通」的敵人是「聯發科」,聯發科擅長移動型與通訊晶片(Chip),輝達(NVIDIA)有 CUDA(酷達) 軟體長牆,兩強結合這是非常高明的商業策略。

資料圖片中,在2023年2月統計,輝達(NVIDIA) 才進入車用市場2年,年成長率60%,CEO 黃仁勳 賺錢能力還是很強的。

Qualcomm 是做手機處理器、Nvidia 是做顯示卡 GPU ,這兩間科技公司成功打入車用市場。

年初, CEO 黃仁勳 應該是意識到在車用市場的競爭者是「高通」, CEO 黃仁勳為了增加在車用市場的勝算,進行與聯發科的策略聯盟。這是一種車用市場這麼大,不如大家一起賺錢的概念。5/29 公開發表會中,聯發科一級主管全都到現場,可見他們的重視。

註:2028年全球有一半的汽車將換成電動車( 碳中和 carbon neutrality)

資料圖片: 由Prasad_Dhond linkedin_202302 提供。

輝達(NVIDIA)有三大類產品1. 高效能伺服器產品(HPC ) 2. 車用半導體 3. 電腦用GPU 顯示卡。 會高速成長的市場排序 會先是1. 高效能伺服器產品(HPC ) 然後,才是2. 車用半導體。

後疫情三大趨勢:

AI 的硬體加速:

備註:CUDA:因為還無法找到比較好的中文翻譯,本文暫時翻譯為 CUDA(酷達)。

----2023/06/22---科技業新聞更新----

大陸公司已經正式採購 NVIDIA 伺服器產品( A800、H800),其中一間公司,字節跳動向輝達(NVIDIA)採購300億台幣(USD$1 Billion) 。這就是我在5/29參加 computex 輝達(NVIDIA)產品發表會聽到最重要一關鍵字「H100 量產」,「量產」這兩個字對於生產端(工廠)非常重要,代表著客戶要下大單,而且「H100」 這個產品是 企業對企業(B2B),輝達(NVIDIA)的美國客戶主要是 Amazon, Meta, Google, Microsoft 等世界前四大科技公司,這裡集結了全世界最聰明的人,這些聰明的人認同輝達(NVIDIA)的H100 產品,才會願意下大單,輝達(NVIDIA)才會有底氣在computex宣告「H100量產」。

--本文以實際的市場需求粉碎 AI 泡沫的謠言-

備註:

輝達(NVIDIA)產品H100每台售價 4萬美元(120萬台幣)。

大陸買的產品是 A800、H800。(美國對大陸的晶片禁令,所以,大陸無法買最新的H100產品)

---------2023/06/22---科技業新聞更新--END---------

輝達(NVIDIA)的產品很多,但,那些產品才會使台廠供應鏈股價大漲才是重點(例如:H100)。

本文寫的很簡短,主要是要突顯輝達的重點產品與未來趨勢。

很榮幸我能為投資界與科技業,搭上溝通的橋樑。

#ai #nvidia #automotive #gpu

2023/6/22

為了保證本文的文章品質,

附上作者簡歷。

Billour Ou 歐育溙簡歷:

2023年 國立雲林科技大學 電機系 碩士班 榜首

2022年 Google 技術主管 (Technical Lead) 面試邀請

2006年 台灣教育部 DSP 競賽全國, 第一名

#ai

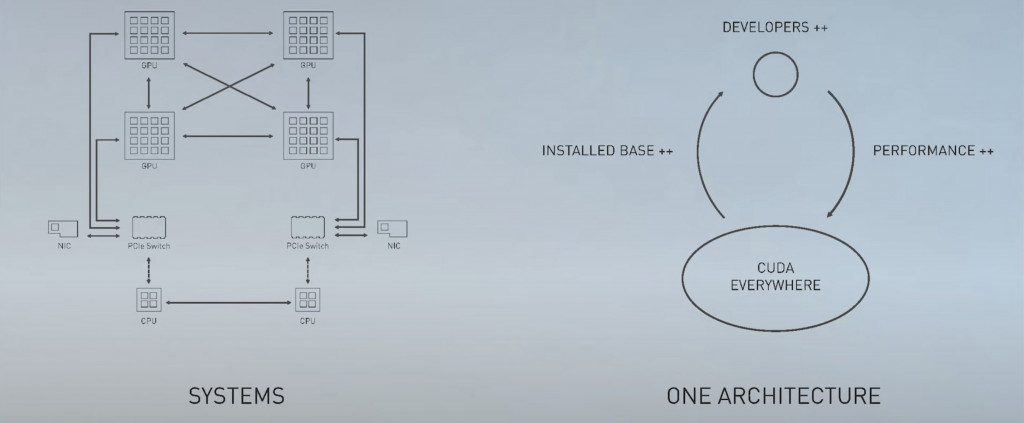

我是資深軟體工程師,我研究所跑去讀電機系,因為未來的市場需求是 AI 的效能調校,現在的各個 IC 設計大廠都在發展自有的軟體架構,來更好操作日益複雜的硬體架構,不論是 CPU, DSP, GPU, FPGA, ASIC 等等的混合式架構。再論 GPU 的 核心數 (core) 越來越多,要怎麼操作 GPU 才會比較方便,所以 NVIDIA 發展 CUDA 軟體架構平台,使一般的資料科學家能更方便的使用 GPU 來進行大量的 AI 運算,最近,NVIDIA 更是進化可以使用 Python 操作 CUDA,稱為CUDA Python 。而 AMD 收購最重要的 FPGA 大廠 Xilinx ,其中一個原因是 Xilinx 有發展 Vitis / Vivado ,你應該沒有想過 FPGA 可以使用 Python 程式語言來實作,你不用寫Verilog Coding 就可以實作一些 AI 專案,因為Xilinx 已經建好底層,你只需要呼叫 Xilinx 的 API,就可以實作 AI 影像辨識非常方便使用。

未來的世界是軟體、硬體整合的世界,

version: 2023072001